Cet article provient d’un mail que j’ai envoyé au mois de juillet 2018. J’ai décidé de publier quelques notes prises lors d’évènements sur le blog afin de publier quelque chose (ça me motivera à terminer mes articles).

L’évènement a eu lieu le 05/07/18. Il rassemblait plusieurs acteurs de santé présentés à la suite pour débattre sur le sujet dans le titre. On peut saluer la diversité des profils conviés.

Chaque présentation durait environ 15 minutes.

Liste des intervenants

La conférence est introduite et conclue par Geneviève Metz, directrice de Télécom Evolution, les débats sont modérés par Alain Tassy, président du groupe Santé de Télécom ParisTech alumni.

Ayant intervenu :

– Dominique Andrieux, Avocat associé, Labonne et associés

– Charles-Etienne de Cidrac, Directeur Santé, Groupe AXA

– Edouard Geoffroy,Responsable Data analytics imagerie France, GE Healthcare

– Guillaume Vogt, Laboratoire de génétique humaine négligée – Inserm (Laboratory of Neglected Human Genetics)

Absent et remplacé :

– Docteur Nourédine Sadeg, spécialiste en toxicologie et pharmacologie clinique

Ayant participé à la table ronde :

– Etienne Bouché, co-fondateur de la startup Kuranda Labs

– Anne-Sophie Taillandier, Directrice de TeraLab à l’IMT

– Alexandre Mignon, Directeur des partenariats et du développement, iLUMENS

– Florent Parmentier, Responsable du laboratoire d’innovations publiques à Sciences Po Paris

Présentations

1. Maître Andrieu : RGPD & Santé

NB : je passe les généralités approximatives sur le RGPD

Le RGPD donne des généralités mais il y a dans l’état actuel de la legislation trop peu de précisions sur les réalités sectorielles.

La notion de gestion par le risque, omniprésente dans le RGPD concernant la sécurité des traitements, est très à la mode dans les textes de lois récents.

Sur certains points, le droit de la santé (code de la santé publique) l’emporterait sur le RGPD soit le cadre légal de l’UE (ah bon ?)

**Les enjeux les plus importants en e-santé **:

– Le consentement

– La sous-traitance

– Les droit à l’oubli et à la rectification (parfois limités par l’intérêt publique)

Commentaire

Une présentation très approximative du RGPD : des concepts clés sont évités ou oubliés, plusieurs graphes censés représenter le RGPD qui ne se contredisent, …

De mon point de vue, voici comment le code de la santé publique ou le droit français peut intéragir avec le RGPD :

– la loi peut imposer de réaliser une activité de traitement donnée. Dans ce cas, cette activité aura pour base une obligation légale, elle n’aura donc pas besoin du consentement des personnes concernées et celles-ci ne pourront pas s’opposer à ce traitement (à moins que la loi ne le permette)

– la loi peut imposer de conserver des données pendant une durée donnée. Dans ce cas, si une personne concernée fait une demande de suppression de ses données, celles-ci seront conservées en archive (mais plus exploitées) la durée légale précisée

A part ces 2 points, je ne vois pas en quoi la loi Française l’emporterait sur la règlementation Européenne. Sans être juriste, c’est la règlementation Européenne qui prime afaik.

Commentaire amusant du maitre de conférence avant la présentation de l’avocat : faites attention aux consultants, ils ne cherchent qu’à faire du chiffre ! Contrairement aux avocats qui sont gratis.

2. M. Brousse d’un laboratoire de toxicologie analytique : Les contrôles toxicologiques en entreprise

Les salariés d’une entreprise peuvent être contrôlés sur leur toxicologie, cela est validé par différentes instances et textes :

– le Conseil d’état

– le Comité consultatif national d’éthique (CCNE) dans son avis 114/2011

– l’Agence nationale de sécurité du médicament et des produits de santé (ANSM) concernant les stupéfiants

Cycle de vie pour les analyses :

1. Prélèvement

2. Pseudonymisation double des données

3. Analyse, compte-rendu et interprétation

Seul le médecin du travail pourra finalement faire le lien entre les analyses et les personnes.

Tout est sécurisé par beeeeeeeeeeeeeeeep (pas plus de détails à ce propos).

Commentaire

C’est encourageant, étant donnée la sensibilité des informations, de voir qu’ils se soucient du RGPD. Espérons qu’ils mènent des analyses d’impact sur la protection des données (PIA, des analyses de risques pour les personnes) de manière convenable et gèrent leurs risques : en cas d’erreur, une personne pourrait se faire diagnostiquer de l’alcoolisme à tort ou encore ses données pourraient être dévoilées et donc violer son respect au secret médical.

3. M. GEOFFROY : Big Data et données en imagerie médicale

DoseWatch rassemble une très grande quantité de méta-données de scan aux rayons et notamment l’exposition aux rayons X de patients sur un grand nombre de centres médicaux.

Cela permet ensuite par exemple de vérifier le taux d’exposition des patients aux rayons et de lever une alerte si un patient risque de dépasser un seuil dangereux qui pourrait lui causer des maux terribles.

Par exemple, un patient pourrait refaire de manière rapprochée des tests déjà réalisés.

Exemples de maux :

– les maux déterminisites, qui parviennent à court terme et sont nécrose de la peau, perte de cheveux, …

– les maux stochastiques, qui sont plus difficile à prévoir et qui peuvent se révéler que bien plus tard et même sans surdose de rayons X, et qui sont des cancers et autres affectations graves

Exploitations possibles de ces données :

– prévention et détection des surdoses

– amélioration des méthods de scan par l’analyse de la qualité des images passées

– optimisation des scans et de l’exposition (jusqu’à -60% par des scans plus fin et précis)

Pour des raisons de secret médical, ils ne sont (qu’ils disent) pas capables de faire le lien avec les personnes. Ils ne peuvent pas non plus rassembler les données de chaque site et doivent se limiter donc aux analyses site par site. C’est très limitant étant donné l’avantage indéniable de la masse d’information dans ces technologies big data.

Commentaire

Il y a une contradiction : ils ne sont pas capables d’identifier les personnes MAIS ne peuvent pas rassembler les radios de différents sites et font leurs analyses séparément ? J’hésite entre être très dubitatif de leur anonymisation des radios mais je ne serais pas non plus surpris qu’ils soient bloqués par d’obscures règlementations protectrices qui, malheuresement, porteraient atteinte à la recherche médicale. On pourrait déplorer un manque de collaboration entre le milieu de la recherche en santé, les législateurs et les juristes…

4. M. Vogt : La collecte de données génétiques en France

On parle là typiquement des entreprises qui donnent des informations essentielles comme :

– les données d’ancestralité (25% italien, 14,2% chinois, 0.1% viking, 176% martien, …)

– le %age de « néandertalité » (sic)

– les prédispositions génétiques et les risques et tolérances détectables

Ces entreprises facturent cher leurs services (j’avais entendu 1000€ l’analyse d’ancestralité ?) et exploitent les données à d’autres fins que l’information à la personne (avec leur « consentement », comprendre le faux consentement pré-RGPD). Elles collectent en général beaucoup d’informations directement auprès des personnes. Un business à 10M de personnes et 10 milliards de $ !!!! Où les personnes sont à la fois les clients ET le produit. Si c’est pas beau ça ? Qu’est-ce qu’on ferait pas pour savoir d’où on vient ?

Ce type de service en France est interdit sans l’intermédiaire d’un médecin ! Bien sûr il est possible de faire appel à des entreprises étrangères. Il existe même des entreprises Françaises qui offrent ce genre de service (ex: myheritage.fr) pourtant illégal.

En France, il y a le principe du patrimoine corporel : on ne peut pas analyser le corps et l’ADN sauf pour des besoins de soin ou pénal. Les laboratoires en France et en Europe arrivent néanmoins à collecter des informations génétiques et du corps pour réaliser des analyses de masse pour la recherche dans l’intérêt publique.

A partir de là, le présentateur parlait à la fois de choses existantes, de projets en cours et de projets futurs et ce n’était pas évident de suivre ce qui était quoi. Les laboratoires constitueraient des banques d’information génétique qu’elles interrogeraient à souhait pour leurs analyses (bien sûr cela est fortement encadré dans l’UE). On peut par exemple avoir besoin de faire des liens entre la couleur des yeux et la qualité de la vue. A ce moment là, on aura besoin d’avoir à disposition tout le patrimoine génétique possible pour la couleur des yeux et en grande quantité. Le présentateur introduit la notion de « consentement dynamique » : on va alors demander aux personnes concernées si elles acceptent que leurs données peuvent être exploitées pour ses recherches.

Encore une fois, difficile à dire ce qui était de l’ordre de l’existant ou des perspectives…

Commentaire

On peut remercier le droit Français de nous protéger de ces conneries sans nom qui n’existent que pour exploiter a posteriori et de manière déloyales les données génétiques (voir cet article de Wired). Quoi de plus personnel et confidentiel que son ADN ? Il est unique, il ne peut pas changer, il raconte énormément de choses sur nous à mesure que la science progresse… J’en connais qui vont tiquer sur le prix de leur assurance 🙂 et c’est sans parler du fait que l’ADN permet (outre les prédispositions génétiques) de savoir qui est noir, qui est roux, qui est [n’importe quel critère habituel de discrimination]. Je ne vais pas développer sur l’importance de la vie privée, ce n’est pas le sujet.

Du point de vue de la recherche par contre, c’est une mine d’or, notamment parce que on ne peut pas remplacer les données génétiques Européennes (par exemple) avec des Asiatiques (autre exemple) car ils ne sont pas interchangeables (on parle bien d’histoire génétique, pas de géopolitique). Puisque chacun possède son ADN (c’est le patrimoine corporel), nous devrions tous pouvoir choisir pour quels types de recherches nos données sont exploitées et participer au débat public sur l’éthique de la recherche génétique.

5. M. De Cidrac : l’action d’AXA dans le domaine des données de santé

Pour celui-ci, j’étais assez sidéré de la sincérité de M. De Cidrac lorsqu’il expliquait comment les assurances étaient la panacée de la société moderne et qu’on ferait mieux de leur ouvrir toutes les données et les laisser nous sauver ! J’ai donc eu du mal à prendre des notes.

Les assurances ont intérêt à ce que leurs assurés se portent le mieux possible : cela réduit évidemment les coûts de remboursements. Ils cherchent donc toujours à réduire le risque. 100 milliars de CA : AXA ou AXA santé ?

AXA assure à peu près tout ce qu’on peut assurer, mais a une longue histoire avec la santé. Aujourd’hui, la santé est le secteur avec la plus grande croissance dans le groupe.

Une de leurs actions est l’analyse de données de santé des salariés d’une société et leur donner un « âge de santé » puis de restituer ces informations de manière généralisée à l’employeur. Je ne me rappelle plus à quoi ça sert.

Commentaire

L’enfer est pavé de bonnes intentions.

Table ronde

Je n’ai pas noté grand chose là-dessus.

Il a été globalement consenti que la législation dans le domaine de la santé et de la protection des données personnelles était trop restrictive et empêchait le progrès dans l’UE vs aux USA ou en Chine.

Note : Personne n’a parlé des historiques de salaires et impayés de 150M d’américains leakés de equifax ou de la surveillance de masse en Chine qui permet (à coups de reconnaissance facial notamment) de retrouver un ennemi du parti en moins de 30 minutes (parmi 1.4milliards d’habitants sur 9.6Mm² c’est quand même fort…).

Mais il y a tout de même du progrès à faire, on cite par exemple le rapport de Cédric Villani (avec qui j’ai discuté dans le RER le we dernier !!) sur l’intelligence artificielle notamment dans la recherche en santé.

Il faudrait pour la moindre startup au moins 1 an et demi pour obtenir un agrément d’hébergement de données de santé (AHDS) ! Ce qui rend le marché complètement impénétrable et qui permet à des dinosaures de perdurer dans les établissements de santé avec des système parfois vieux de plus de 30 ans et pas toujours (rires) mis à jour régulièrement et portés vers les systèmes d’exploitation plus récents.

Pas d’information sur le CHDS, mais cela n’est a priori pas plus simple pour les petites entreprises.

Apparemment, OVH serait AHDS mais pas Amazon (Amazon Web Services) ou Google (Google Cloud).

Un doyen ancien médecin très éloigné du phénomène informatique et des enjeux autour des données pose plusieurs questions très intéressantes et pertinentes sur le marché de la donné dans le Monde : sait-on précisément quantifier la valeur de la donnée et de ces marché dans le Monde ? Est-ce devenu un actif stratégique ? Et d’autres questions en plein dans le mille auxquelles personne bien sûr n’a pu donner de réponse…

Conclusion

On garde le sentiment général qu’en France et dans l’UE la recherche est plus difficile (mais possible) qu’aux US&A ou en Chine.

Malgré ça, les gens restaient positifs et conscients des enjeux que cela relève et de l’importance des valeurs de l’UE.

Le fait est que le marché est là et que la masse de données de santé des européens est une valeur protégée que ne peuvent pas complètement exploiter les acteurs étrangers. Notamment du point de vue génétique, la majorité des gènes européens se trouvant en Europe.

Globalement, le RGPD n’est pas compris et est vu comme une difficulté de plus pour leurs activités. Malgré qu’il y ait une grosse redondance entre différentes lois et normes (RGPD, ISO27000, CHDS, I&L, …) c’est trop difficile aujourd’hui de se faire guider sur tous ces sujets simultanément.

En conclusion, on peut donc considérer qu’il y a plus de demande que d’offre sur le marché de la protection des données en santé et que c’est un sujet globalement obscur pour ces acteurs ! A vos CHDS !

Florilège

« faites attention, ce que cherchent les consultants, c’est vendre » société capitaliste quand tu nous tiens…

« le cloude » (pour dire l’infonuagique)

« sécurisé par un phénomène de cryptage des pdf » celle là on me l’avait jamais faite, pas même avec vous savez qui !

« monitorage » bientôt le monitoraging

Voilà ce qu’on devrait apprendre dans les écoles : http://bitoduc.fr

Notes de fin

Sur l’article

Comme dit en introduction, je publie ici d’anciennes notes. J’ai dû m’appliquer en les rédigeant la 1ère fois et je les ai relues pour ajouter les commentaires à chaque intervenant, j’espère donc que le qualité sera à peu près au rendez-vous.

Sur le blog

Aïe. C’est vraiment pas évident de terminer ses articles. J’en ai démarré plusieurs que j’ai mis en pause ou à l’arrêt. J’espère en publier au moins un par mois en cette année de grâce 2019.

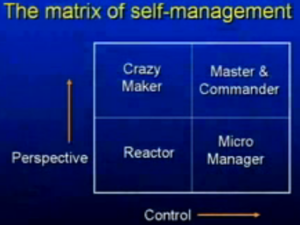

Matrice GTD de la maitrise de soi[/caption] (oulala c’est moche !)

Matrice GTD de la maitrise de soi[/caption] (oulala c’est moche !)